De leigo para curioso

Midia

Marolando entre história e conceitos

A expressão Inteligência Artificial (IA) surgiu em 1956 na Darthmouth College Conference, em Hanover – New Hampshire (EUA), através do convite “Uma proposta para a pesquisa de verão do Darthmouth College sobre inteligência artificial”, assinada por J. McCarthy (Dartmouth College); M. L. Minsky (Harvard University); N. Rochester (I.B.M. Corporation); C. E. Shannon (Bell Telephone Laboratories) (Época Negócios, 2019; Sichman, 2021).

Na referida proposta constava que que “[...] um grupo de dez homens realizasse um estudo de dois meses [...]”, enfocando que “[...] A tentativa será feita para descobrir como máquinas podem criar linguagem, formar abstrações e conceitos, resolver problemas restritos a humanos e até melhorar elas mesmas [...]”. As temáticas discutidas seriam “computadores automáticos”; “como pode um computador ser programado para usar uma linguagem”; “redes de neurônios”; “teoria do tamanho do cálculo”; “autoaperfeiçoamento”; “abstrações”; “aleatoriedade e criatividade”. No encontro haveria divulgação regular de pesquisas e os membros podiam trabalhar individualmente e em pequenos grupos (Época Negócios, 2019).

Observa-se na trajetória da IA que ocorreram oscilações ao longo do tempo entre metas previstas e resultados alcançados, alternando períodos de desânimo ou euforia, maior ou menor modismo vigente, para o qual Sichman (2021) apresentou três causas motivadoras: i) baixo investimento de processamento e memória; ii) informações recentes, como as redes neurais profundas; iii) acessibilidade crescente de informações disponíveis na internet, nas redes e mídias sociais, associadas sempre a dúvidas e incertezas, nos mais diversos aspectos, devidamente justificados.

Ainda conceitual e academicamente sem um conceito convergente e definitivo, a IA foi caracterizada como a tecnologia aplicada pela engenharia para desenvolver máquinas e/ou programas computacionais inteligentes. Melhor ainda, caminhando par e passo ao entendimento da funcionalidade da inteligência humana, para conseguir replicá-la artificialmente por uma programação de computador ou robô controlado por um computador, com o objetivo de apresentar um desempenho impressionante da execução das tarefas associadas à inteligência e discernimento comumente humanos (Britannica, 2023; Redação National Geographic, 2023).

Apesar de ainda não haver IA capaz de executar as múltiplas tarefas possíveis ao ser humano comum, quando tratadas as tarefas específicas, a substituição da ação humana já é realidade, como exemplo de modismo, a ferramenta de linguagem ChatGPT, que simula conversas e cria textos similares à interação humana (Britannica, 2023; Redação National Geographic, 2023). Mais ainda, algumas programações alcançaram níveis de desempenho superiores em tarefas especializadas como a elaboração de diagnósticos médicos, mecanismos de busca de computador e reconhecimento de voz ou caligrafia (Britannica, 2023; Redação National Geographic, 2023). Contudo, independentemente do aumento da velocidade de processamento e da capacidade de memória dos computadores, ainda não constam programas que substituam a flexibilidade humana ou o conhecimento cotidiano.

Segundo Sichman (2021) a atuação da IA converge em uma coleção de modelos, técnicas e tecnologias (ex. busca; raciocínio e representação de conhecimento; mecanismos de decisão, percepção, planejamento, processamento de linguagem natural; tratamento de incertezas; aprendizado de máquina), as quais isoladamente ou agrupadas, promovem soluções, através de princípios (Sichman, 2021, p. 39), assim sumarizados:

- simbólico: inicia identificando o conhecimento do domínio (modelo do problema), para representá-lo numa linguagem formal e estabelecer um mecanismo de inferência para utilizar esse conhecimento;

- conexionista: adoção de uma linguagem, que é uma rede de elementos simples, inspirada no funcionamento do cérebro, onde neurônios artificiais, conectados em rede, são capazes de aprender e de generalizar, a partir de exemplos. O raciocínio consiste em aprender diretamente a função entrada-saída. Matematicamente, trata-se de uma técnica de aproximação de funções por regressão não linear;

- evolutivo: utiliza um método probabilístico de busca de soluções de problemas (otimização); estas soluções são representadas como indivíduos, aos quais se aplicam técnicas “inspiradas” na teoria da evolução como hereditariedade, mutação, seleção natural e recombinação, selecionando às gerações seguintes os indivíduos que maximizam uma função objetivo;

- probabilístico: adota modelos para representar o conceito estatístico de independência condicional, a partir de relacionamentos causais no domínio. A inferência consiste em calcular a distribuição condicional de probabilidades dessa distribuição, e em alguns casos particulares de topologia, existem algoritmos bastante eficientes.

Nas últimas duas décadas vêm sendo desenvolvidos sistemas de camadas de filtragem para tomada de decisão pela IA, como os sistemas sociotécnicos (SST), os quais abordam a interação humano-agente. No call-center os elementos técnicos fornecem subsídios para que humanos possam tomar decisões, mas a inserção de IA nesses sistemas possibilitou que os próprios elementos técnicos possam tomar algumas decisões, como as respostas automatizadas de atendimentos por celulares ou internet, numa conversa lógica entre humano e IA (Sichman, 2021).

O autor supracitado, citando Virginia Dignum (2019), ressaltou o filtro de responsabilidade, ética e previsibilidade ao desenvolvimento, uso e potenciais consequências da IA considerando que: i) equipes estejam atentas quanto aos riscos e consequências potenciais do uso; ii) haja adequação e controle das capacidades de raciocínio ético nos agentes inteligentes; iii) sejam estabelecidos regulação adequada e processos de certificação.

Ainda, ressaltou da autora a abordagem “ART of AI”, que enfoca os valores envolvidos e princípios éticos das relações humanos/máquinas/humanos, destacando três pontos: a) transparência nas trocas e monetização entre os parceiros, usuários e todos que direta/indiretamente interagem no sistema; b) responsabilidade direta dos desenvolvedores associada à capacidade dos sistemas de IA pelas decisões autônomas, auto exposição na identificação de erros e/ou resultados de desconformidades, mesmo aleatórios; c) transparência ao descrever, inspecionar e reproduzir a sistemática de decisões, bem como, as formas de aprendizagem de adaptação da IA e à governança dos dados criados e utilizados. O princípio e o fim focais seriam similares ao da arte, para benefícios e a serviço ético, funcional e saudável da/para humanidade.

Nesse foco da autonomia e responsabilidade, o Responsible Artificial Intelligence Agents Workshop (Sichman, 2021; apud Raia, 2019), evento satélite do AAMAS 2019 (International Conference on Autonomous Agents and Multiagent Systems), realizado em Montreal (Canadá), reuniu pesquisadores de IA, ética, filosofia, robótica, psicologia, antropologia, ciências cognitivas, direito, estudos de governança regulatória e engenharia, para discutir e trabalhar sobre os desafios relacionados ao projeto e à regulamentação de sistemas de IA. Esse é um exemplo da interdisciplinaridade desse campo de estudo.

Assim, estão sendo criados centros interdisciplinares de formação, pesquisa e informação, como o UK Research and Innovation (UKRI), agência britânica de fomento que atua com universidades, organizações de pesquisa, empresas, instituições de caridade e governo. Contemporaneamente a UKRI apoiou a abertura de 16 Centros de Treinamento de Doutorado em IA, os quais buscaram capacitar 1.000 doutorandos, em diversas áreas como saúde, mudanças climáticas, ética e música. Destaca-se dentre esses, o Centre for Doctoral Training in Safe & Trusted AI (STAI, 2019), envolvendo o King’s College e o Imperial College, em Londres.

Apesar do nível avançado de desenvolvimento de sistemas de IA, ainda há riscos envolvidos. Sichman (2021), citando Thomas Dietterich e Eric Horvitz (2015), caracterizou cinco classes de garantia necessárias para mitigar os riscos inerentes aos sistemas de IA, quais sejam:

- falhas: necessidade de práticas de qualidade similares aos sistemas de software, como sistemas de piloto automático testados e validados;

- segurança: os sistemas de IA são tão vulneráveis quanto qualquer outro software aos ataques cibernéticos, demandando medidas preventivas de controle de alterações ao comportamento desses sistemas;

- aprendiz de feiticeiro: na interação com pessoas qualquer sistema de IA deve não apenas executar comandos, mas analisar reações dentro da “normalidade” ou “razoabilidade” social;

- autonomia compartilhada: dimensionar riscos sobre fluidez de engajamento e clareza sobre estados internos e objetivos dos envolvidos no sistema em tempo real, o que ainda é limitado, ou seja, não é possível dimensionar riscos entre a relação de sistemas autônomos de IA e usufruto humano, na expectativa da superação do primeiro sobre o segundo, como a ficção já tem descrito como uma preocupação real;

- impactos socioeconômicos: estabelecer impactos negativos da IA na distribuição de empregos e na economia, muito além da ciência e engenharia da computação, tangíveis às políticas e programas socioeconômicos, inserindo a dimensão de que o aumento de produtividade seja compartilhado.

É realidade que as empresas da economia mundial, como as Big Techs, utilizam técnicas de IA que impactam no cotidiano, trabalho, interações sociais, cuidados de saúde, privacidade, justiça e segurança, em ações de paz e guerra, implicando vieses de ética, legalidade, governança e responsabilidade, de pesquisadores, decisores políticos, indústria e sociedade.

Mas, ainda hoje, considera-se que os algoritmos de IA utilizados são como caixas-pretas, não permitindo inspeções de gestão de dados e respectivas proveniências, resultados e dinâmica funcional. Como a IA busca desenvolver técnicas e modelos computacionais que solucionam problemas, Sichman (2021) recomendou substituir a expressão “a IA da empresa X”; pela menos glamorosa e mais precisa assertiva de “um sistema da empresa X que utiliza técnicas de IA”.

Sichman (2021) parafraseou uma afirmação do fundador da Cibernética, Norbert Wiener, no artigo “Some Moral and Technical Consequences of Automation”, publicado na revista Science (1960), “Se usarmos, para atingir nossos objetivos, um órgão mecânico em cujo funcionamento não podemos interferir de forma eficaz ... é melhor estarmos bem certos de que o propósito colocado na máquina é aquele que realmente desejamos”.

Na força da onda das aplicações da IA

Ludemir (2021) ressaltou que as máquinas realizam trabalhos manuais e racionais, atividades que demandam inteligência. Como exemplo temos os carros autônomos e independentes, sem motoristas do Google e da Tesla, em fases distintas de regulação. São usados em ambientes reais, em situações diversas e de riscos, neste caso específico para usuários e transeuntes (apud Feng et al., 2021).

Há robôs que realizam diagnósticos precisos, tendo como caso curioso, o robô desenvolvido pela empresa iFlytek que foi aprovado no exame nacional para licenciamento de médicos da China (LUDEMIR, 2021, apud SARACCO, 2017). O “Médico Assistente robô” registra os sintomas dos pacientes, analisa as imagens de tomografia computadorizada e realiza o diagnóstico inicial, não sendo substituto do médico, mas ampliando sua atuação e eficiência (Ludemir, 2021).

Ainda, uma aplicação de larga empregabilidade e continuada melhoria são os tradutores automáticos, onde a IA é aplicada pelo Processamento de Linguagem Natural. Destacam-se os sistemas eficientes de Visão Computacional a partir de 2012, aplicando-se a técnica de Rede Neural 2012, culminando no reconhecimento facial padrão DeepFace, que identifica rostos humanos em imagens digitais e consegue detectar quem são as pessoas que estão nas fotos independentemente do ângulo. Algumas plataformas estão adotando os Sistemas de Recomendação com IA associando preferências e fazendo recomendações aos usuários, como Amazon (livros e produtos), Netflix (filmes e séries), Spotify (músicas).

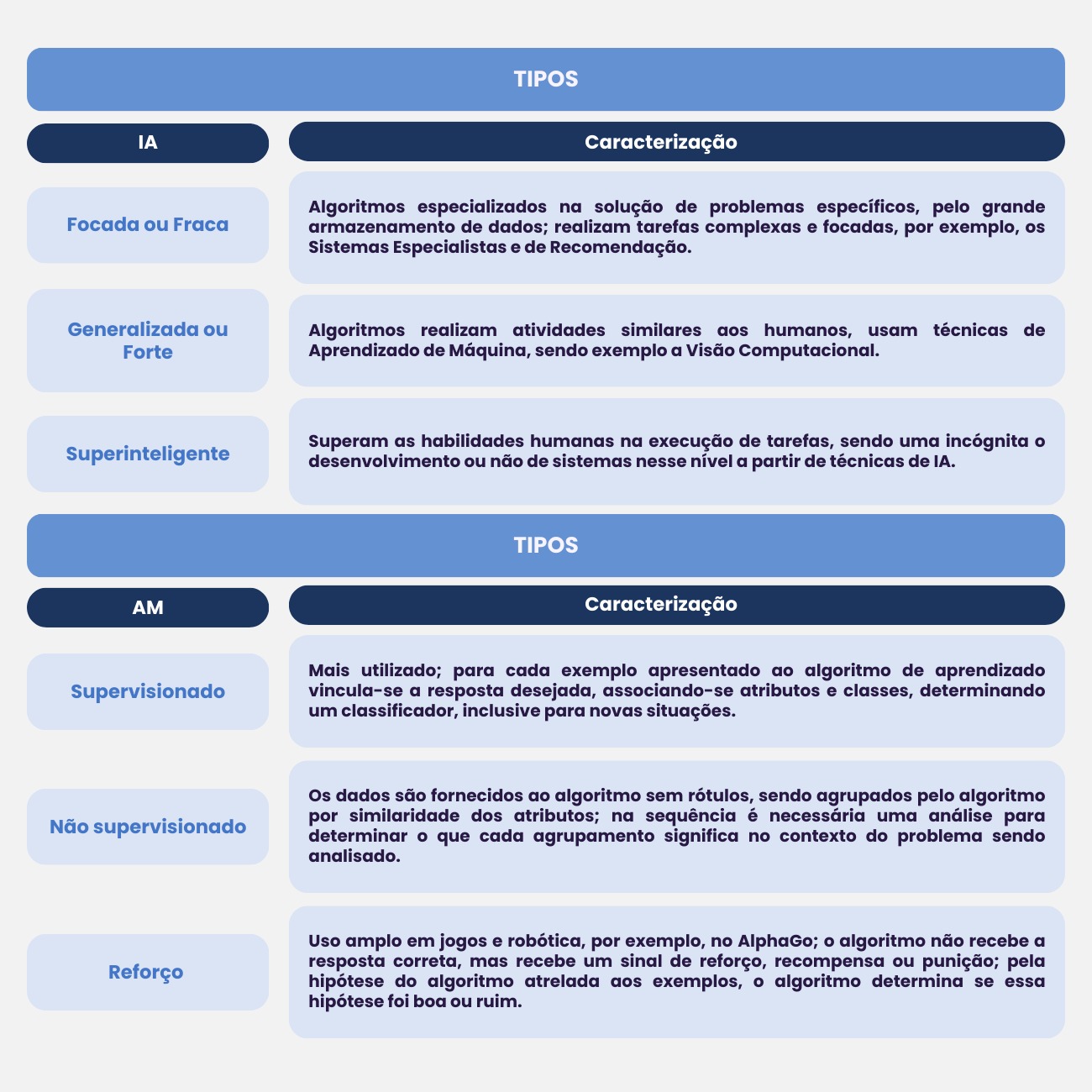

Outra técnica de IA é o Aprendizado de Máquina (AM), em que o computador está continuamente adquirindo novas habilidades por meio de acesso irrestrito a vastos bancos de dados, e que se tornou chave para colocar conhecimento nos computadores. As aplicações de IA nesse caso possibilitam o treinamento de algoritmos e uso do aprendizado de máquina, similar ao aprendizado humano (Ludemir, 2021). A caracterização dos três tipos de IA e de Aprendizagem de Máquina constam no Quadro 1.

Dentre as técnicas de AM destacam-se as Redes Neurais Artificiais, que são modelos matemáticos desenvolvidos a partir de 1943 (tentando copiar as estruturas neurais biológicas), que estabelecem a capacidade computacional adquirida por meio de aprendizado. Na atualidade, para soluções de problemas complexos, foram estabelecidas as Redes Neurais Profundas (Deep Neural Networks) com várias camadas escondidas, novamente inspiradas pela sensibilidade local e orientação seletiva do cérebro. Foram idealizadas para extrair implicitamente características relevantes dos dados de entrada (Ludemir, 2021).

Quadro 1 - Caracterização didática dos tipos de Inteligência Artificial (IA) e Aprendizagem de Máquina (AM)

Fonte: Adaptado de Ludemir (2021).

A aplicabilidade e uso da IA têm sido impactantes na contemporaneidade, com seus potenciais bônus e ônus, como a substituição de ações humanas repetitivas por tarefas executadas por máquinas; melhorias nos serviços de saúde; processamento natural: voz para texto, tradução; melhorias na educação; energia limpa e barata; detecção de fraudes; meios de transportes mais seguros (aplicativos de transporte), rápidos (rota otimizadas) e limpos.

Contudo, tornam-se realidade a invasão de privacidade, o uso mercadológico de informações pessoais, a perda de vagas de trabalho, a possibilidade de ampliação de desigualdades sociais, adoção de armas bélicas, dentre outras questões tratadas globalmente, de solução indeterminada. Se desconhece o quanto a máquina - em desenvolvimento e atualização continuada - demanda aprender para solucionar tarefas complexas. O sistema humano de aprendizagem funciona por correlação para solução de novos problemas dinâmicos, então pode se prever para os próximos anos o aperfeiçoamento de muitas aplicações que já estão sendo resolvidas parcialmente, tais como: análise de sentimentos; personalização de ensino, saúde, lazer, investimentos; robôs domésticos, veículos autônomos; detecção de posicionamento; captura de ironia, humor, sarcasmo; interpretação de tom e intenção de fala (Ludemir, 2021).

Em pesquisa realizada pelo Instituto de Liderança do Diretor Executivo, foi mostrado que 42% dos 119 CEOs norte-americanos entrevistados, dentre empresas como Walmart, Coca-Cola, Xerox e Zoom, convergem sobre a opinião de insegurança e avanço descontrolado da influência das técnicas de IA nas máquinas que possam desenvolver tarefas associadas aos seres humanos. Uma percepção bastante sombria e alarmante ao pesquisador Jeffrey Sonnenfeld (Yale University– EUA) (Valbão, 2023).

Fernandes (2023) reportou que algumas profissões absorverão novas ferramentas, mas não serão substituídas por IA nas inovações na área de automação, tais como: Psicologia: demanda processo empático de conexão e atendimento; Serviço Social: pautado na interação humana e atendimento humanizado; Pedagogia: atua no desenvolvimento cognitivo e intelectual dos indivíduos no processo de aprendizagem e educação; Docência: envolve a formação humana de personalidade e cidadania por meio de habilidades socioemocionais, comunicativas e interativas; Cientista de Dados e profissionais da Tecnologia da Informação: desenvolvedores e operadores de sistemas, atualizando, ajustando, corrigindo os processos das interações máquina-homem.

Samuel Benjamin Harris, filósofo e neurocientistanorte-americano, numa palestra em Junho (2016), alertou para dicotomia entre interrupção do progresso da IA ou a continuidade de aprimoramento ao infinito, em que “construiremos máquinas mais inteligentes que nós, e uma vez que isso acontecer, elas aperfeiçoarão a si mesmas. E nós arriscamos o que o matemático I. J. Good chamou de "explosão de inteligência", onde o processo poderia fugir do controle.”.

IA na ficção e nas questões éticas e filosóficas

A fascinação pela IA e máquinas robóticas humanoides capazes de interagir com humanos vem sendo refletida em histórias de ficção científica há mais de sete décadas. Para além de encantar públicos de todas as idades, essas obras guiam pesquisas e trazem reflexões sobre a tecnologia e suas aplicações (Bordignon, 2022). Diversas pesquisas na área de interface homem-máquina têm como inspiração invenções, conceitos, designs e aplicações oriundas de obras de ficção científica (Jordan e cols., 2018, citados por Bordignon, 2022).

Dois exemplos muito icônicos são os livros da série “Robôs” (1954-1985), de Isaac Asimov, e “2001, uma Odisseia no Espaço” (1968), de Arthur C. Clarke.

Nos livros de Asimov, apesar de autônomos, os robôs são regidos pelas famosas 3 leis da robótica, programadas em seus cérebros positrônicos e que garantem que eles não se voltem contra os seres humanos: 1ª Lei - Um robô não pode ferir um ser humano ou, por inação, permitir que um ser humano sofra algum mal; 2ª Lei - Um robô deve obedecer às ordens que lhe sejam dadas por seres humanos, exceto nos casos em que entrem em conflito com a Primeira Lei; 3ª Lei - Um robô deve proteger sua própria existência, desde que tal proteção não entre em conflito com a Primeira ou Segunda Leis (Bordignon, 2022). Nessas obras, a interação humano-máquina é, de maneira geral, benéfica aos seres humanos, apesar dos dilemas, dificuldades e aparentes paradoxos presentes nas narrativas.

No livro de Arthur Clarke, a IA assume uma postura de dominação em relação ao ser humano, reagindo de forma ameaçadora quando contrariada, gerando reflexões acerca do possível alcance de um elevado senso de autopreservação nas máquinas, que pode levar a um futuro catastrófico, onde robôs e IAs se voltem contra o ser humano e eventualmente assumam o controle da sociedade.

Essas reflexões e preocupações não se limitam às obras de ficção. Os debates éticos e filosóficos sobre o futuro das IAs são profundos e buscam trazer à luz os riscos envolvidos. Um dos pontos de discussão envolve o alcance da singularidade tecnológica, que seria o ponto hipotético em que a inteligência artificial ultrapassa a capacidade humana de compreensão e passa a se autoaperfeiçoar e se autorreplicar (Lug, 2023). Se, eventualmente, as máquinas se tornarem mais inteligentes do que seres humanos, corremos o risco de vê-las tomando suas próprias decisões, sejam elas benéficas à raça humana, ou não. Assim, é importante que haja diretrizes consistentes sobre o uso de IAs para garantir que sempre exista alinhamento aos interesses humanos e bem-estar da sociedade (Lug, 2023).

Stephen Hawking, físico teórico, afirmou que “A criação bem-sucedida de inteligência artificial seria o maior evento na história da humanidade. Infelizmente, pode também ser o último, a menos que aprendamos a evitar os riscos” (Martin, 2019).

Essas preocupações tornam-se mais patentes na medida em que surgem avanços visíveis nas capacidades dos robôs humanoides. Hoje, há robôs com expressões humanas, capazes de manter conversas sobre os mais diversos assuntos e demonstrar sarcasmo e ironia, como o robô Sophia, desenvolvido pela Hanson Robotics, uma empresa de Hong Kong dedicada a criar máquinas sociais inteligentes. Sophia foi o primeiro robô cidadão, tendo ganhado cidadania saudita em 2017, tornando-se o primeiro robô a ter personalidade legal em algum país. Ainda em 2017, Sophia foi declarada o primeiro robô Embaixador da Inovação pela Organização das Nações Unidas. Sophia já foi entrevistada em programas de televisão e é capaz de fazer reflexões sobre si mesma, contar piadas e demonstrar empatia.

Considerado o pai da computação, o matemático Alan Turing sugeriu, em 1950, uma técnica para distinguir a inteligência artificial da inteligência humana, o Teste de Turing, ou jogo da imitação. Seu famoso artigo tem início com o seguinte questionamento: “As máquinas podem pensar?” (Turing, 1950).

O teste avalia se uma pessoa é capaz de determinar se está conversando com um computador ou com outro ser humano, em uma interação feita através de teclado e monitor (Lug, 2023). O Teste de Turing levanta questões importantes sobre a natureza da mente humana e da consciência. Se uma máquina pode ser programada para imitar o comportamento humano, isso significa que a mente humana é simplesmente uma máquina programada de forma diferente? (Lug, 2023).

Ainda, considerando que a própria humanidade está sujeita a dilemas éticos e sociais, onde benefícios para alguns podem representar malefícios para outros, como no caso de uma guerra, como submeter uma IA a uma lógica “neutra”? (Bordignon, 2022).

Como Gilberto Gil, em sua música “Cérebro eletrônico”, 1ª faixa do disco homônimo lançado em 1969 pela Philips: fiquei matutando e inferi que a IA faz quase tudo, comanda, desmanda, mas não sente a liberdade de uma caminhada, além do que, somente nós podemos sorrir com um(a) filho(a), como também apenas nós vivenciamos as incertezas da vida e a certeza da inevitável morte.